GRU

2020, Jul 08

LSTM和GRU相对于RNN来说多出了gate,能够有效的避免Short-term Memory的问题。

LSTM有三个门:forget gate, input gate 和 output gate, 还有一个 cell state

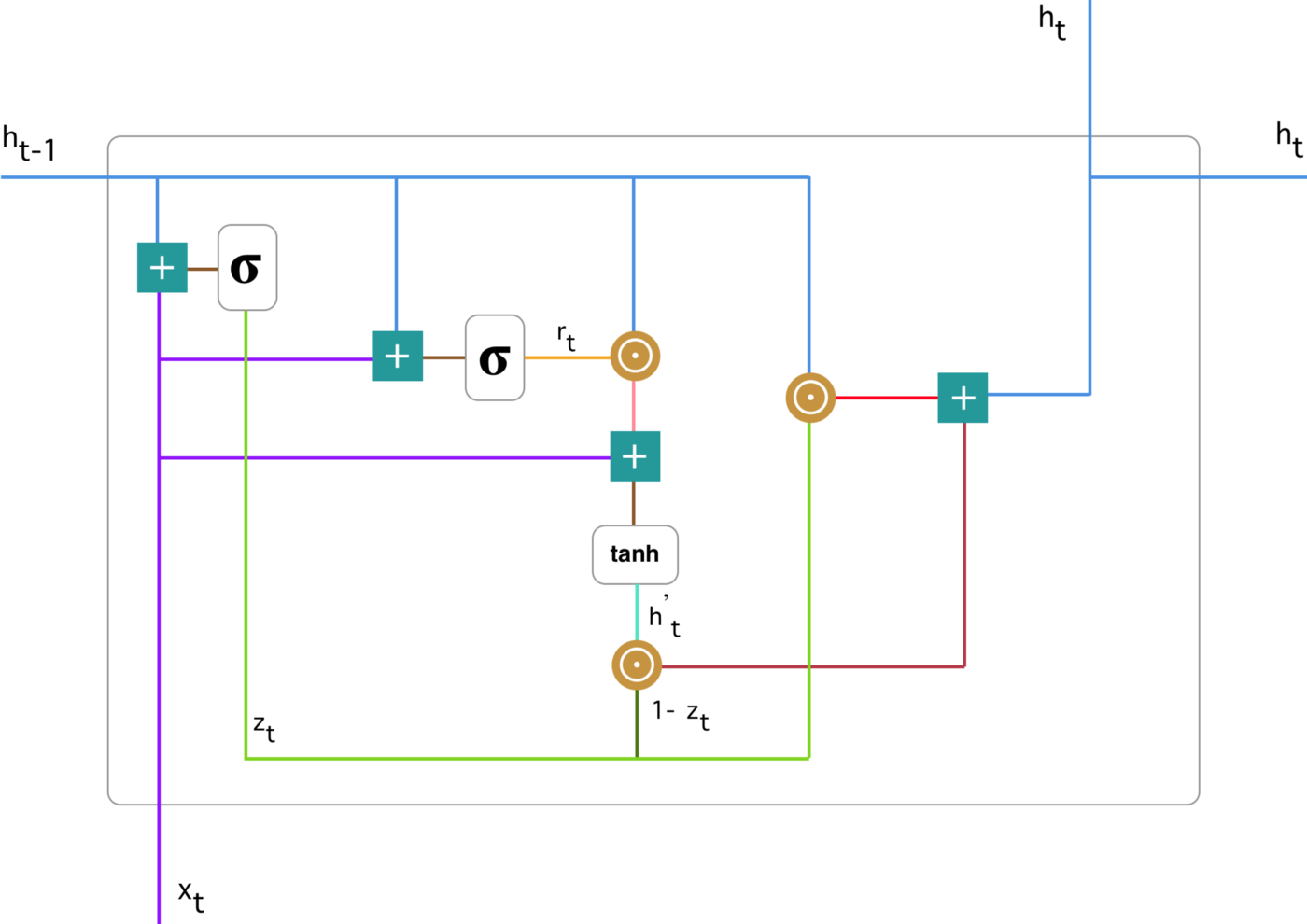

GRU

简要记录下GRU的基本计算过程,gru算子的理解可以参考最后的References

GRU有两个门:reset gate 和 update gate

update gate计算

[u_t=act_g(W_{ux}x_t + W_{uh}h_{t-1})]

reset gate计算

[r_t=act_g(W_{rx}x_t + W_{rh}h_{t-1})]

current memeory content计算

[h^{‘}{t}=act_c(W{cx}x_t+W_{ch}(r_t \odot h_{t-1}))]

output memory content

[h_t=u_t \odot h_{t-1} + (1-u_t) \odot h^{‘}_{t}]